Статистика зависимостей в котировках (теория информации, корреляция и другие методы feature selection) - страница 15

Вы упускаете торговые возможности:

- Бесплатные приложения для трейдинга

- 8 000+ сигналов для копирования

- Экономические новости для анализа финансовых рынков

Регистрация

Вход

Вы принимаете политику сайта и условия использования

Если у вас нет учетной записи, зарегистрируйтесь

Люди, у которых стоит EViews, такие вопросы не задают, хи-хи

Будьте любезны, не могли-бы скинуть, в личку или сюда, EViews, если это возможно?

Люди, у которых стоит EViews, такие вопросы не задают, хи-хи

Ну да, вопрос глупый, согласен. Гарантии такие же, как и на саму модель.

А у Вас какая версия стоит? Говорят, что "пятерка" устаревшая.

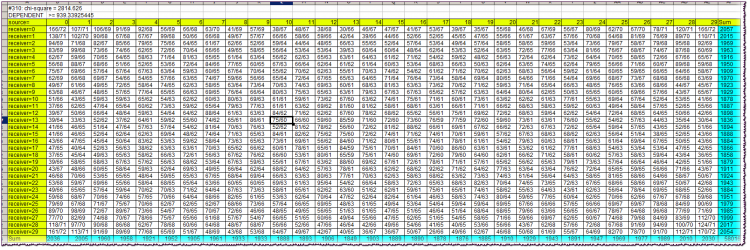

Первая строка блока: #310: chi-square = 2814.626Вначале - значение переменной Lag. Затем - значение критерия хи-квадрат независимости переменных.

Вторая строка: заключение о зависимости/независимости, вместе с граничным значением хи-квадрата.

Желтые клетки таблицы - шапки. Позволяют ориентироваться, какие символы алфавита наблюдались одновременно на пересечении соответствующих строки и столбца. Напоминаю, что алфавиты у источника и приемника тождественны и равны квантилям, в которые попали возвраты соответствующих баров (источника и приемника).

Например, на пересечении столбца source=10 и строки receiver=13 находим значение ячейки 75/60. Это означает, что сочетание "возврат источника (бара в прошлом), попавший в 10-й квантиль, и возврат приемника (бара ближе к настоящему), попавший в 13-й квантиль" наблюдалось 75 раз в истории, причем теоретическое количество таких сочетаний равно 60, если бы они были независимыми.

Бирюзовые клетки - это суммы фактических частот по строкам или столбцам, необходимые для расчета хи-квадрата.

Сам хи-квадрат в случае независимости источника и приемника должен быть почти всегда меньше граничного, т.е. указанного во второй строке блока. Как видим, он намного больше, почти в 3 раза. Это указывает на очень сильную зависимость баров в данном случае.

Весь файл, даже архивированный, занимает много места, выложить тут не могу.

Ну да, вопрос глупый, согласен. Гарантии такие же, как и на саму модель.

А у Вас какая версия стоит? Говорят, что "пятерка" устаревшая.

Есть шенноновское определение энтропии, в котором независимость обязательна.

А есть определение взаимной информации, в котором шенноновское определение применяется чисто формально, т.к. все же предполагается, что зависимости существуют.

Если Вам хочется покопаться в философских глубинах и противоречиях определения взаимной информации - пожалуйста, копайтесь. Я предпочел бы не париться по этому поводу и просто пользоваться "американской" формулой с вероятностями, не заморачиваясь по поводу независимости.

Немного не так. Перевод смыслов кора..., ТИ заключается в следующем. Есть понятие энтропии. Нужно четко осознавать что за этим красивым и непонятным иностранным словом скрывается некая искусственно придуманная цифра. В учебниках, тех что по-честнее, так прямо и пишут, аксиоматически введенная мера неопределенности. Как она получается, - фактически это свёртка. Грубо говоря, большая таблица описывающая состояния и их частоты, с помощью арифметических формул сворачиваются в одно число. При чем сворачиваются только частоты, а сами состояния (у которых кстати, то же могут быть свои меры) интересны лишь с точки зрения общего их количества.

В тер.вере. есть похожая операция, если грубо говорить, то мо системы считают похожим образом. Но только там вероятности состояний перемножают с их мерами, суммируют и получают цифру, о которой потом доказывают теоремы о сходимости и т.д. Здесь не так. Здесь в качестве меры выступает сама частота (называют её вероятностью), точнее её логарифм. Логарифм позволяет решить некоторые арифметические проблемы, которые Шеннон сформулировал в трех условиях (должнО монотонно рости и т.д.).

После этого Шеннон говорит: - Друзья, знаете, я придумал разумные и очевидные правила как можно складывать недавно открытые мною циферки, которые я назвал энтропия, из двух разных табличек. Друзья (преимущественно люди военные) спрашивают: - Прекрасно, и как же? - А очень просто. - отвечает им Шеннон, сверкая глазами. - Допустим, одна табличка с другой никак не связана, ну независимые они, бывает так в жизни. И по этому поводу у меня есть теорема о сложении энтропий, с замечательным результатом - циферки нужно просто сложить! - Прекрасно, а если таблички каким то непостижимым образом связаны? - Тут всё то же просто, строим одну большую квадратную табличку из двух исходных, в каждой клеточке перемножаем вероятности. Складываем циферки в клеточках по столбцам, отдельно складывает по колонкам, строим новую таблицу, делим одно на другое, тут рано нулю, тут рыбу заворачивали... Оп-ля, в результате получаем одно число, которое я назвал условной энтропией! Что интересно, условную энтропию можно посчитать как от первой таблички ко второй, так и наоборот! И что бы учесть эту досадную двойственность, мною придумана полная взаимная энтропия, и это то же одна циферка! - И чо, - спрашивают друзья, жуя поп-корн, - А то, что сравнивать одну циферку с другой гораздо легче, чем разбираться в сути данных из исходных таблиц. И уж тем более легче когда нужно понимание смыслов и надежности взаимосвязей - это ведь скучно, разбираться. Занавес.

Вот так выглядит краткая история ТИ в моём исполнении. Составлена по мотивам моих собственных изысканий и утверждений академического словарика (см. цитаты ранее).

Теперь, что важно. Ключевой момент во всей этой истории скрыт в условной энтропии. Фактически, если хочется оперировать одной цифрой, не нужно считать ни каких взаимных информаций и прочего, достаточно освоить методику подсчёта условной энтропии. Именно она будет давать некую меру взаимосвязи одного с другим. При этом, нужно понимать, что цифры в табличках должны быть "стационарны", и кроме того, взаимосвязи табличек то же должны быть "стационарны". И кроме того, исходные циферки в таблички должны попадать из соответствующих источников.

Нужно сказать, что существуют расширения ТИ на случаи цепей Маркова. Вроде бы то что доктор прописал. Но нет, переходные вероятности для рынка непостоянны, в силу общей нестационарности. Кроме того, если для ЦМ неважно как система оказалась в текущем состоянии, для рынка это очень важно.

Я не знаю, что такое Ваш алфавит задачи. У меня есть система из пары баров, разделенных расстоянием Lag. Один бар, в прошлом, - это источник, а второй - приемник. Алфавиты обоих идентичны (конечно, если говорить о возвратах баров).

Понятно, что то похожее на автокорреляцию, но только с другой мерой. Возражения мои точно такие же как и для случая ЦМ. Ну и все прочии, стационарность и др.

ЗЫ. Нужно сказать, что если Вы действительно это (ТИ) торгуете и успешно, то бох с ним, с возражениями. Пусть хоть заячия лапка на мониторе, если это помогает.

Почитал HideYourRichess.

Да, интересно. Действительно, матрица частотности условных состояний системы - в предположени о наличии связи - будучи переформулированной в термины условной энтропии, дает нам ОДНУ цифру, характеризующую возможность наличия некоторой детерминированности одной переменной от другой. Если PDF в такой исходной матрице будет равномерной, то мы имеем максимальную энтропию системы (конечно, я хотел сказать, условную энтропию). А ежели есть неравномерности, энтропия будет меньше. Как первое приближение можно и одной цифирей обойтись. Это Вы верно подметили. А взаимная инфа для множества переменных, отделенных от приемника понятием Lag, как написал Алексей, рассчитывается уже для вполне конкретных целей, а именно, для целей отбора информативных переменных.

Пока, я лично не торгую при помощи ТИ. Этот топик был "первой пробой пера", я думаю дальше.

HideYourRichess: Вот так выглядит краткая история ТИ в моём исполнении. Составлена по мотивам моих собственных изысканий и утверждений академического словарика (см. цитаты ранее).

Очень интересно. Наворотил кашу Шеннон такую, что до сих пор разбираемся...

Нужно сказать, что существуют расширения ТИ на случаи цепей Маркова. Вроде бы то что доктор прописал. Но нет, переходные вероятности для рынка непостоянны, в силу общей нестационарности. Кроме того, если для ЦМ неважно как система оказалась в текущем состоянии, для рынка это очень важно.

В том-то и дело, что поток возвратов - не марковский процесс, т.к. возврат нулевого бара сильно зависит от возврата не только первого бара, но и второго, третьего и т.п. Во всяком случае, именно так можно напрямую интерпретировать основное исследование ветки.

ЗЫ. Нужно сказать, что если Вы действительно это (ТИ) торгуете и успешно, то бох с ним, с возражениями. Пусть хоть заячия лапка на мониторе, если это помогает.

Нет, не торгую. Но очень интересно было бы развить это до чего-то торгового. Слышал от alsu (пропал Алексей куда-то, жаль), что смутно помнит он передачу на канале РБК, в которой выступал некий краснобай-трейдер, реально торгующий нечто похожее. И ставит на это, гад, неслабые деньги. И называет он свою систему "ловлей неэффективности рынкета".

А об энтропиях давненько уже размышляю. И даже здесь что-то вываливал. Но тогда это было скорее похоже на энтропию статфизики, а не ТИ, и относилось к мультивалюткам. В-общем, карма что-то такое энтропийное нашептывает на ухо уже несколько лет, ну а я к ней прислушиваюсь и все пытаюсь понять, что же она от меня хочет-то...

В том-то и дело, что поток возвратов - не марковский процесс, т.к. возврат нулевого бара сильно зависит от возврата не только первого бара, но и второго, третьего и т.п. Во всяком случае, именно так можно напрямую интерпретировать основное исследование ветки.

Нет, не торгую. Но очень интересно было бы развить это до чего-то торгового. Слышал от alsu (пропал Алексей куда-то, жаль), что смутно помнит он передачу на канале РБК, в которой выступал некий краснобай-трейдер, реально торгующий нечто похожее. И ставит на это, гад, неслабые деньги. И называет он свою систему "ловлей неэффективности рынкета".

А об энтропиях давненько уже размышляю. И даже здесь что-то вываливал. Но тогда это было скорее похоже на энтропию статфизики, а не ТИ, и относилось к мультивалюткам. В-общем, карма что-то такое энтропийное нашептывает на ухо уже несколько лет, ну а я к ней прислушиваюсь и все пытаюсь понять, что же она от меня хочет-то...

Очень любопытно.

Но не могли бы Вы, Алексей, более чётко сформулировать ( по своей таблычке) какой гипотезе о распределении возвратов соответствуют оценки хи-квадрат?

Приснописному "броуну", или что-то покруче?

;)